Обама — король США (и готовит переворот)

Google пытается отвечать на вопросы в поисковой выдаче. Иногда получается не очень

Поисковик Google уже несколько лет экспериментирует с выносом ответов на заданный пользователем вопрос прямо в поисковую выдачу — чтобы не приходилось кликать по ссылкам. Из-за шумихи вокруг фейковых новостей, которые активно распространяются через соцсети, журналисты издания Vice обратили внимание на содержание таких «быстрых ответов» от гугла. Обнаружилось, что с ними много проблем.

В феврале 2016 года преподаватель истории в университете Кейс Вестерн Резерв (штат Огайо) Питер Шульман читал лекцию о возрождении Ку-клукс-клана в 1920-х. Один из студентов поинтересовался, был ли 29-й президент США Уоррен Гардинг членом этой ультраправой организации.

Шульман признался, что ничего об этом не слышал. После этого другие студенты стали подтверждать предположение своего одногруппника. Чтобы «выяснить» принадлежность Гардинга к Ку-клукс-клану, они просто вбили в поиск соответствующий запрос. На первом месте в выдаче гугла был большой блок — сниппет — со списком из американских президентов, которые якобы состояли в организации.

Список «президентов-расистов» взят с сайта Trent Online, который называет себя «нигерийской интернет-газетой». Статья опиралась на ненадежные источники и содержала ложную информацию. Гардинга действительно обвиняли в членстве в Ку-клукс-клане, но биографы не нашли этому никаких подтверждений. Сам президент также отрицал свое участие в Клане. Свидетельств того, что другие приведенные в списке политики состояли в ультраправой организации, тоже нет.

Google начал давать ответы прямо в выдаче в 2014 году. Информацию для них поисковик берет из двух типов источников. Первый — «граф знаний», большая база данных о фактах, людях и связях между ними, которую корпорация строит с 2012 года.

Другой, менее надежный тип источников, — интернет. Поисковик анализирует статьи «Википедии», заметки на других сайтах и даже посты в соцсетях и выбирает оттуда информацию для ответа. Так как в интернете можно написать все, что угодно, иногда гугл показывает неверные ответы.

Первый громкий случай произошел еще в 2015 году. Когда пользователи спрашивали у поисковика, что случилось с динозаврами, тот показывал выжимку статьи с христианского сайта, в которой утверждалось, что никаких динозавров не было. После того как о случае написали СМИ, ответ заменили на корректную цитату.

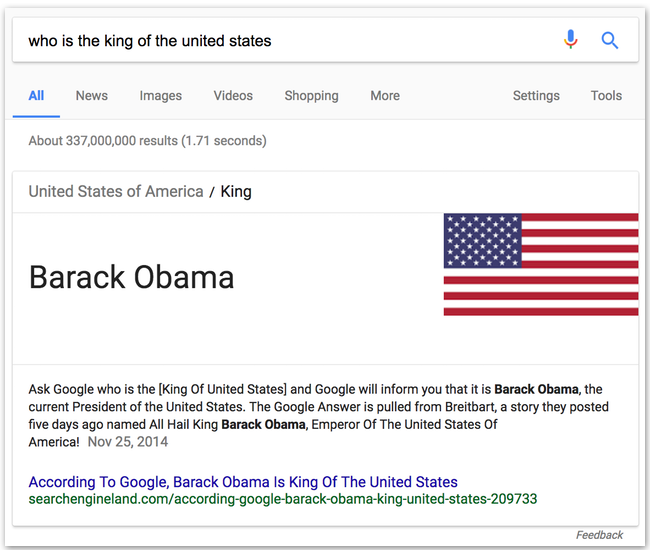

Но в последнее время выдаче гугла начали появляться не столь курьезные неправильные ответы. Поисковик убеждал пользователей, что бывший президент США Барак Обама собирается ввести военное положение и готовит государственный переворот. А также называл политика «королем Соединенных Штатов», сначала ссылаясь на соответствующую статью, а затем — на заметку о том, что гугл называет Обаму «королем США».

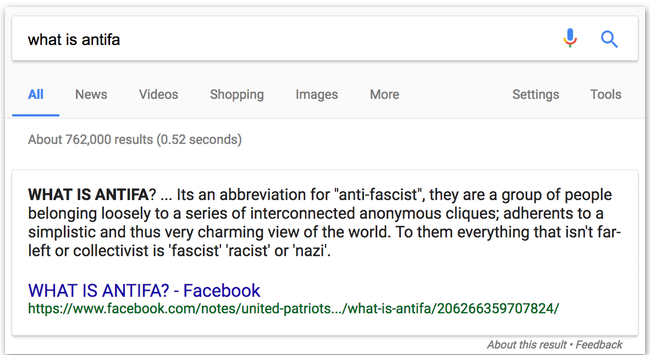

На вопрос об опасности глутамата натрия гугл показывал информацию с сайта, выступающего против вакцинации, а информацию о движении «антифа» брал со страницы австралийской националистической организации. По запросу «почему пожарные машины красные» выдавалась безумная шутка от «Монти Пайтон» (ее сильно локализованную версию можно прочитать здесь).

Есть как минимум две причины полагать, что Google все же не откажется от попыток вытаскивать ответы на вопросы прямо в выдачу. Во-первых, очень часто это именно то, чего хотят пользователи — быстро узнать ответ на интересующий вопрос, не кликая по ссылкам.

Во-вторых, эта функция остро необходима в устройствах с голосовым интерфейсом. Когда пользователь задает вопрос «умной колонке» (например, Google Home), он вряд ли готов слушать перечисление 10 первых ссылок в выдаче, — ему просто нужен ответ. И Google Home уже использует данные, которые представлены в сниппетах поиска. Результаты иногда выходят ужасающие: на вопрос «женщины — зло?» устройство как-то зачитало цитаты о том, что «каждая женщина немного проститутка».

После статьи в The Guardian, вышедшей в декабре 2016 года, Google изменил текст ответа. Но в марте 2017-го Google Home уверенно рассказывала о том, что Обама готовит военный переворот.

Редактор сайта Search Engine Land Дэнни Салливан говорит, что плохие ответы всегда будут появляться в выдаче гугла — потому что поисковик сам по себе не может сказать, является ли правдой тот или иной факт, приведенный в интернете. «Компания может использовать все свое машинное обучение и алгоритмы, чтобы делать более корректные предположения, но иногда и они будут ошибаться. А когда предположение ошибочно, оно может быть по-настоящему ужасным», — считает Салливан.

Google отказалась отвечать на конкретные вопросы издания Motherboard о сниппетах с ответами. В компании отметили, что если какая-то информация не соответствует действительности, пользователь может сообщить об этом — под каждым сниппетом с ответом есть кнопка, позволяющая отправить исправление.